Mở Đầu

Trong thời đại số hóa, dữ liệu lớn (Big Data) đã trở thành nguồn tài nguyên vô giá đối với các ngành công nghiệp, đặc biệt là trong lĩnh vực tài chính – ngân hàng. Việc phân tích và dự đoán khả năng vỡ nợ của khách hàng dựa trên dữ liệu khoản vay không chỉ giúp các ngân hàng đưa ra các quyết định tín dụng chính xác hơn mà còn giúp giảm thiểu rủi ro tài chính. Thông qua việc áp dụng Big Data, các mô hình phân tích dữ liệu khoản vay có khả năng khai thác các thông tin ẩn sâu trong hàng triệu giao dịch và hồ sơ vay vốn, từ đó dự đoán chính xác những trường hợp có khả năng vỡ nợ cao. Đây là chìa khóa để các tổ chức tài chính nâng cao hiệu suất hoạt động, giảm thiểu rủi ro và tạo ra lợi thế cạnh tranh bền vững.

Giới Thiệu Apache Spark Trong Big Data

Giới Thiệu Apache Spark

Ngày nay có rất nhiều hệ thống đang sử dụng Hadoop để phân tích và xử lý dữ liệu lớn. Ưu điểm lớn nhất của Hadoop là được dựa trên một mô hình lập trình song song với xử lý dữ liệu lớn là MapReduce, mô hình này cho phép khả năng tính toán có thể mở rộng, linh hoạt, khả năng chịu lỗi, chi phí rẻ. Điều này cho phép tăng tốc thời gian xử lý các dữ liệu lớn nhằm duy trì tốc độ, giảm thời gian chờ đợi khi dữ liệu ngày càng lớn.

Dù có rất nhiều điểm mạnh về khả năng tính toán song song và khả năng chịu lỗi cao nhưng Apache Haddop có một nhược điểm là tất cả các thao tác đều phải thực hiện trên ổ đĩa cứng điều này đã làm giảm tốc độ tính toán đi gấp nhiều lần.

Để khắc phục được nhược điểm này thì Apache Spark được ra đời. Apache Spark có thể chạy nhanh hơn 10 lần so với Haddop ở trên đĩa cứng và 100 lần khi chạy trên bộ nhớ RAM.

Apache Spark là một framework mã nguồn mở tính toán cụm, được phát triển sơ khởi vào năm 2009 bởi AMPLab. Sau này, Spark đã được trao cho Apache Software Foundation vào năm 2013 và được phát triển cho đến nay.

Tốc độ xử lý của Spark có được do việc tính toán được thực hiện cùng lúc trên nhiều máy khác nhau. Đồng thời việc tính toán được thực hiện ở bộ nhớ trong (in-memories) hay thực hiện hoàn toàn trên RAM.

Spark cho phép xử lý dữ liệu theo thời gian thực, vừa nhận dữ liệu từ các nguồn khác nhau đồng thời thực hiện ngay việc xử lý trên dữ liệu vừa nhận được ( Spark Streaming).

Spark không có hệ thống file của riêng mình, nó sử dụng hệ thống file khác như: HDFS, Cassandra, S3,…. Spark hỗ trợ nhiều kiểu định dạng file khác nhau (text, csv, json…) đồng thời nó hoàn toàn không phụ thuộc vào bất cứ một hệ thống file nào.

Ưu điểm Apache Spark

- Xử lý dữ liệu: Spark xử lý dữ liệu theo lô và thời gian thực

- Tính tương thích: Có thể tích hợp với tất cả các nguồn dữ liệu và định dạng tệp được hỗ trợ bởi cụm Hadoop.

- Hỗ trợ ngôn ngữ: hỗ trợ Java, Scala, Python và R.

Phân tích thời gian thực:

- Apache Spark có thể xử lý dữ liệu thời gian thực tức là dữ liệu đến từ các luồng sự kiện thời gian thực với tốc độ hàng triệu sự kiện mỗi giây. Ví dụ: Data Twitter chẳng hạn hoặc luợt chia sẻ, đăng bài trên Facebook. Sức mạnh Spark là khả năng xử lý luồng trực tiếp hiệu quả.

- Apache Spark có thể được sử dụng để xử lý phát hiện gian lận trong khi thực hiện các giao dịch ngân hàng. Đó là bởi vì, tất cả các khoản thanh toán trực tuyến được thực hiện trong thời gian thực và chúng ta cần ngừng giao dịch gian lận trong khi quá trình thanh toán đang diễn ra.

Thành Phần Apache Spark

Apache Spark bao gồm 5 thành phần chính: Spark Core, Spark Streaming, Spark SQL, MLlib, và GraphX, mỗi thành phần cung cấp các tính năng riêng biệt, phục vụ cho các yêu cầu khác nhau trong xử lý dữ liệu lớn

- Spark Core:

- Nền tảng chính của Spark, chịu trách nhiệm điều phối và thực thi các tác vụ trên các cụm máy.

- In-memory computing: Tính năng xử lý dữ liệu trong bộ nhớ, giúp tăng tốc độ xử lý so với việc đọc/ghi liên tục từ ổ đĩa.

- Hỗ trợ tích hợp với các hệ thống lưu trữ: Có thể tham chiếu dữ liệu từ nhiều nguồn khác nhau như HDFS, Cassandra, HBase, và S3.

- Spark Streaming:

- Cho phép xử lý dữ liệu thời gian thực hoặc gần như thời gian thực từ nhiều nguồn như Kafka, Flume, TCP sockets.

- Chuyển đổi dòng dữ liệu thành các mini-batch nhỏ và xử lý chúng bằng cách sử dụng các API của Spark Core.

- Hỗ trợ fault-tolerance (khả năng chịu lỗi) và scalability (khả năng mở rộng).

- Spark SQL:

- Cung cấp API cho truy vấn dữ liệu sử dụng ngôn ngữ SQL truyền thống.

- Cho phép tích hợp với dữ liệu có cấu trúc và nửa cấu trúc, ví dụ như JSON, Parquet, và ORC.

- Hỗ trợ truy vấn bằng ngôn ngữ SQL, nhưng có thể tích hợp với DataFrame API và DataSet API để tương thích với các ngôn ngữ lập trình như Java, Scala, và Python.

- MLlib:

- Thư viện học máy (Machine Learning) tích hợp sẵn trong Spark, hỗ trợ các thuật toán như phân loại, hồi quy, phân cụm, và các bộ lọc cộng tác.

- Cung cấp các API đơn giản, dễ sử dụng để thực hiện các phép biến đổi dữ liệu và xây dựng các mô hình học máy trên dữ liệu lớn.

- Hỗ trợ In-memory computing, giúp tăng tốc độ huấn luyện mô hình so với các nền tảng xử lý truyền thống.

- GraphX:

- Thư viện xử lý đồ thị và phân tích đồ thị trong Spark.

- Hỗ trợ các thao tác trên đồ thị như xây dựng đồ thị, tính toán các chỉ số của đồ thị (PageRank, Shortest Path, Connected Components).

- Tích hợp với API của Spark giúp khai thác sức mạnh xử lý đồ thị dựa trên khả năng tính toán phân tán.

Support Vector Machines Apache Spark

Support Vector Machines (SVM) trong Apache Spark là một trong những thuật toán học máy mạnh mẽ và phổ biến được cung cấp bởi thư viện MLlib của Spark. SVM chủ yếu được sử dụng cho các tác vụ phân loại và hồi quy, đặc biệt là trong các tình huống cần xử lý dữ liệu lớn nhờ khả năng phân tán và xử lý song song của Spark.

SVM trong Spark MLlib:

- Phân loại tuyến tính: Spark cung cấp mô hình SVM hỗ trợ cho việc phân loại dữ liệu tuyến tính, thích hợp cho các tập dữ liệu lớn và phức tạp.

- Xử lý dữ liệu lớn: SVM trong Apache Spark có khả năng xử lý trên các cụm máy với dữ liệu phân tán, tối ưu hóa tốc độ xử lý nhờ khả năng tính toán trong bộ nhớ của Spark.

- Stochastic Gradient Descent (SGD): Spark sử dụng thuật toán SGD để tối ưu hóa hàm mất mát trong quá trình huấn luyện mô hình SVM, giúp tăng tốc độ huấn luyện.

- Hỗ trợ nhiều định dạng dữ liệu: SVM có thể được huấn luyện trên dữ liệu có cấu trúc dưới dạng DataFrame hoặc RDD trong Spark, đồng thời tích hợp dễ dàng với các nguồn dữ liệu bên ngoài như HDFS, Cassandra, hoặc HBase.

- Tương thích với hệ sinh thái Spark: Mô hình SVM có thể dễ dàng tích hợp với các thành phần khác của Spark như Spark SQL để truy vấn dữ liệu, hoặc Spark Streaming để xử lý dữ liệu thời gian thực.

SVM trong Spark được ứng dụng rộng rãi trong nhiều lĩnh vực như phát hiện gian lận, phân loại hình ảnh, phân loại văn bản, và nhiều bài toán phân loại khác yêu cầu khả năng mở rộng để xử lý khối lượng dữ liệu lớn.

Thực Nghiệm

Tập Dữ Liệu

Link tải tập dữ liệu tại đây

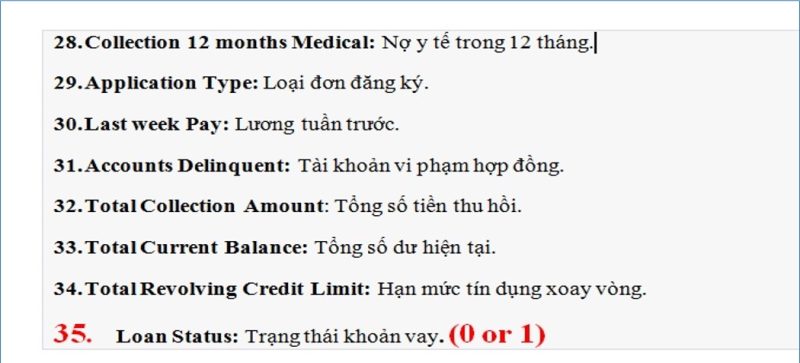

Thuộc Tính Dữ Liệu

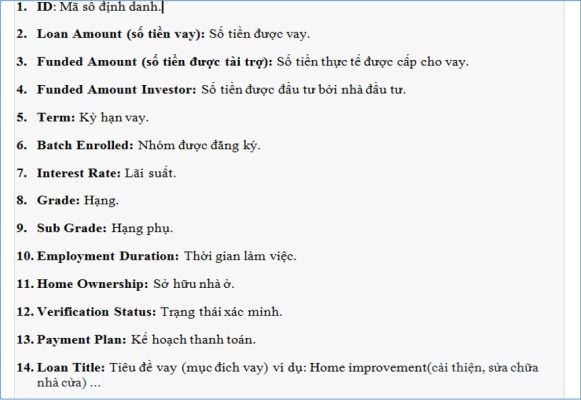

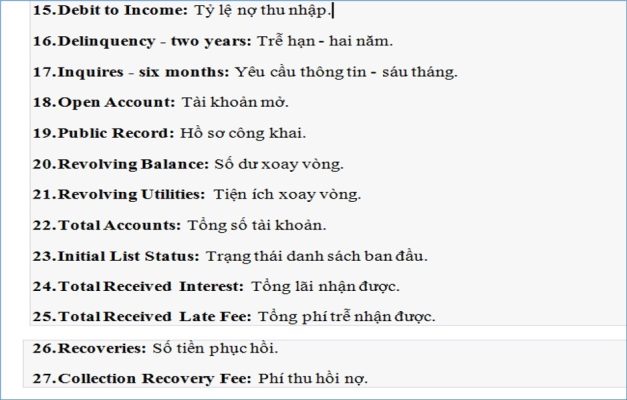

35 thuộc tính dữ liệu cho bài toán Big Data Phân Tích Khoản Vay Ngân Hàng & Dự Đoán Vỡ Nợ:

Chạy Thực Nghiệm

Code chạy thử nghiệm tải tại đây

Kết Luận

Việc kết hợp SVM (Support Vector Machines) với Apache Spark đã chứng minh là một giải pháp hiệu quả và mạnh mẽ trong việc dự đoán vỡ nợ dựa trên phân tích dữ liệu khoản vay ngân hàng. Spark cung cấp khả năng xử lý dữ liệu lớn trên nền tảng phân tán, giúp tối ưu hóa cả về thời gian huấn luyện và dự đoán.

Sử dụng SVM trong Spark không chỉ mang lại hiệu suất cao khi xử lý dữ liệu lớn, mà còn giúp dễ dàng tích hợp với các thành phần khác trong hệ sinh thái Spark. Điều này cho phép việc tiền xử lý dữ liệu, trích xuất đặc trưng, và đánh giá mô hình diễn ra trơn tru, góp phần xây dựng các mô hình học máy mạnh mẽ và toàn diện hơn. Ngoài ra, khả năng kết hợp với các công cụ khác trong Spark, như Spark SQL hoặc MLlib, giúp hệ thống trở nên linh hoạt hơn trong việc quản lý và phân tích dữ liệu đa chiều.

Như vậy, Apache Spark đã cung cấp một nền tảng mạnh mẽ và tối ưu cho việc triển khai các thuật toán như SVM, đặc biệt là trong các bài toán dự đoán quan trọng như dự đoán vỡ nợ. Sự tích hợp chặt chẽ giữa SVM và Spark giúp các doanh nghiệp tận dụng tối đa hiệu quả từ dữ liệu, đảm bảo tính liên tục trong hoạt động kinh doanh và hỗ trợ quyết định chiến lược tài chính một cách chính xác và nhanh chóng.

Hi vọng bài viết “Big Data Phân Tích Khoản Vay Ngân Hàng & Dự Đoán Vỡ Nợ” chia sẻ những kiến thức hữu ích để các bạn có cái nhìn về Big Data và sự kết hợp với các thuật toán máy học trong việc phân tích, dự đoán trên dữ liệu lớn như các ứng dụng mà nó mang lại.

![Series [CA]: Phần 2 Create SAN Certificate](https://phuongit.com/wp-content/uploads/2024/10/San-Cert.png)